Understanding Verifier's Law: Why AI Excels at Tasks That Are Easy to Verify

在最近 Jason Wei 的一次公开演讲中,他提出了一个非常有意思的观点:验证者法则(Verifier's Law)。这个法则指出:一个任务的解决方案越容易被验证,就越容易训练AI去攻克它。换句话讲,任务的验证难度越低,AI进步的速度就越快。

Jason Wei 曾是 Google Brain 的一名研究科学家,长期致力于探索AI的发展规律和未来趋势,他在 OpenAI 任职期间主导了 o1, o3, Deep Research 等包含思维推理和链式思考模型的开发。在该演讲后次日,新闻消息称 Jason Wei 已离开 OpenAI 并加入 Meta。

什么是验证的不对称性?

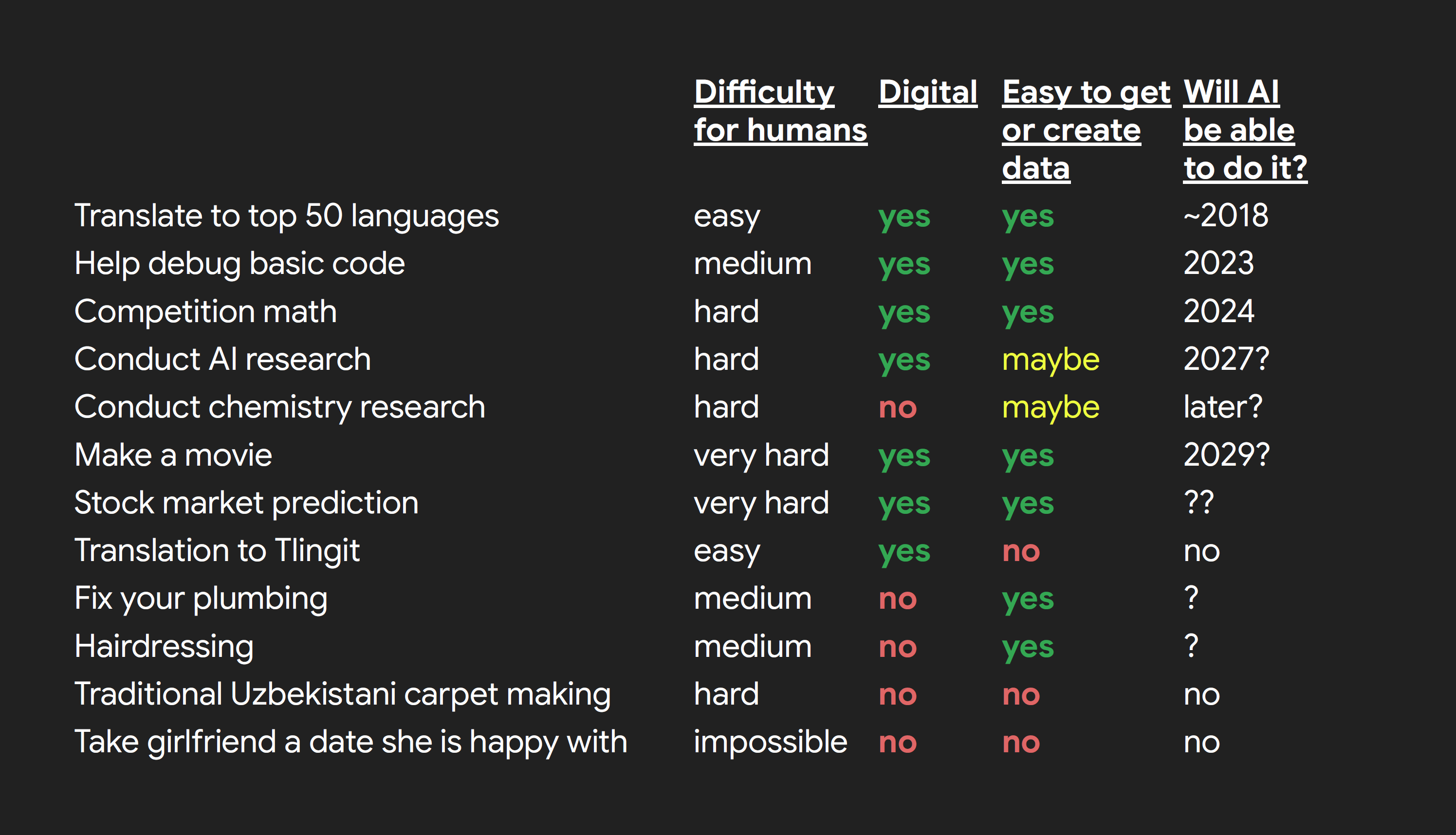

为什么有些任务 AI 能快速掌握,而另一些却止步不前?这背后隐藏着任务本身的验证难易度差异。举一些直观的例子来说明:

- 数独(Sudoku):解出一个数独可能很复杂,但只需几秒钟即可验证解答是否正确。

- 大型网页应用:构建复杂,但只需打开网页即可快速判断其是否正常运行。

- 数据处理脚本:编写起来可能相对容易,但他人验证却需要仔细阅读代码或进行大量测试。

- 竞赛级数学题:解题和验证一样困难,通常需要重新完整地推导一次。

- 新闻或新理论的生成:容易撰写或提出,但验证真实性或有效性却异常困难,耗费大量资源。

AI为什么最擅长“生成难但验证易”的任务?

从上面的例子中我们可以发现,AI的优势在于反复尝试和快速优化。这依赖于一个关键条件:明确且迅速的反馈信号。而验证简单的任务正好提供了这样的信号,这正是强化学习(reinforcement learning)、进化搜索(evolutionary search)和自对弈(self-play)能够取得巨大成功的基础。

决定验证难易度的五大因素

Jason Wei在演讲中总结了影响任务验证性的五个关键因素:

- 客观真值(Objective Truth):任务是否存在唯一且明确的正确答案(如数学题),而非依赖主观判断(如艺术创作)。

- 验证迅速性(Fast to Verify):能否快速完成验证,比如运行单元测试或答案匹配。

- 验证的可扩展性(Scalable to Verify):是否能自动化地批量验证大量答案,如 AI 模型的自动评测。

- 低噪声(Low Noise):验证结果是否稳定、一致,而非受主观因素或随机波动影响。

- 连续奖励(Continuous Reward):是否能够提供连续而非简单二元的反馈,例如提供明确的得分指标帮助AI逐步优化。

一个任务的验证性越高,就越容易被AI掌握。

AlphaEvolve:验证者法则的成功实践

验证者法则最引人注目的实际验证之一,是 Google DeepMind 于 2025 年开发的AI系统 AlphaEvolve。AlphaEvolve 利用迭代验证不断进化解决方案,实现对极其困难问题的攻克。它由 Google Gemini 驱动,本质上是一个自动化流水线,协调多个大型语言模型(LLM)进行代码或设计改进,并采用进化方法:生成大量候选解 → 自动评分 → 筛选优化 → 多轮迭代提升。

AlphaEvolve 在实际中攻克了多个此前认为仅限顶级专家解决的难题,例如:

- 算法优化:首次改进了 Strassen 的矩阵乘法算法,创造了半个世纪以来的首次突破

- 几何最优化:推动了经典的高维几何问题“Kissing Number”的已知极限

- 组合设计:成功解决了复杂的最小六边形拼装问题

- 系统优化:优化 Google 数据中心的调度算法及电路硬件设计

AlphaEvolve 的成功证明了明确、快速、连续的反馈机制能够极大提升AI在复杂任务中的表现。

AI基准测试的兴起与验证者法则的关系

回顾一下近年来AI基准测试的发展,不难发现所有知名AI测试,如问答、翻译、图像分类、编程挑战等,都具备明确、快速、自动化的验证机制。例如,从学术考试(如MMLU)到小学数学(GSM8K)再到竞赛数学(MATH)和编程挑战(HumanEval、SWE-Bench),AI 的迅速进步离不开这些清晰明确的评测方式。

如今,大型语言模型(LLM)已经在多个明确的基准测试上达到甚至超越人类专家的水平,这再次印证了验证者法则的正确性。

如何提升AI的表现?提升可验证性是关键

Jason Wei提出的验证者法则还为实践带来了重要的启示:要想推动AI在某个任务上的进步,最有效的方式之一就是提高任务本身的可验证性。

比如,在软件工程领域,明确的测试用例能够极大提升AI编写代码的能力,因为 AI 可以在每次尝试后立刻运行测试套件来获得反馈。这正是 SWE-Bench 基准的核心:AI 写出函数 → 自动运行测试 → 反馈哪些部分正确或失败 → 可迭代优化。这一流程将原本复杂的代码生成任务,转化为一个有明确规则的游戏。再比如,数学竞赛题往往具有明确的标准答案,模型通过大量尝试并立即验证答案的方式获得快速进步。

归根结底,清晰的反馈机制(Ground Truth)能够让复杂任务变得像强化学习中的游戏一样简单明了。

对 AI 未来研究的启示

验证者法则告诉我们一个重要趋势:

- 首先被 AI 攻克的任务,必然是那些具有明确评估标准的任务,如代码编写、数据清洗、明确优化任务等

- 反之,缺乏良好评估标准的任务(如创意评估、伦理判断)进展相对缓慢。人类对这些任务一样有着执着的追求,但 AI 仍然难以胜任这些工作

如果一个任务的成功标准可以被清晰地定义,那么 AI 迟早可以完美掌控这个任务。反之,如果任务的成果无法被衡量,那么自动化地 AI 模型训练将是无稽之谈。下一波 AI 突破需要解决的,可能不是建模或训练技术,而是如何发明出能衡量复杂或主观任务的新方法。

总结

“可衡量性”决定了 AI 最先征服哪些任务。

验证者法则强调了:“能被清晰衡量的任务,AI迟早会攻克;难以衡量的任务,则需要我们去发明新的衡量方式。” 我们可以预见,AI 在未来的进展将首先出现在验证容易的领域。 而未来一大关键研究方向,将是发明更好的衡量方法,去扩展 AI 能力边界。

参考文章:

Asymmetry of verification and verifier's law - Jason Wei

AlphaEvolve: A Gemini-powered coding agent for designing advanced algorithms

转载请标注来源